GPT는 인류 역사상 최고의 기술적 진보 중 하나입니다. 코드를 모르는 사람이 코딩을 할 수 있게 만들었으며, 언어를 몰라도 그 언어를 이해할 수 있었으며, 지난 시간 BetaAI라는 사이드프로젝트를 참여하면서 배운건 현재 발전된 AI를 잘 사용한다면, 이전에 저희가 하고 싶었던 일을 해낼 수 있다는 점이었습니다.

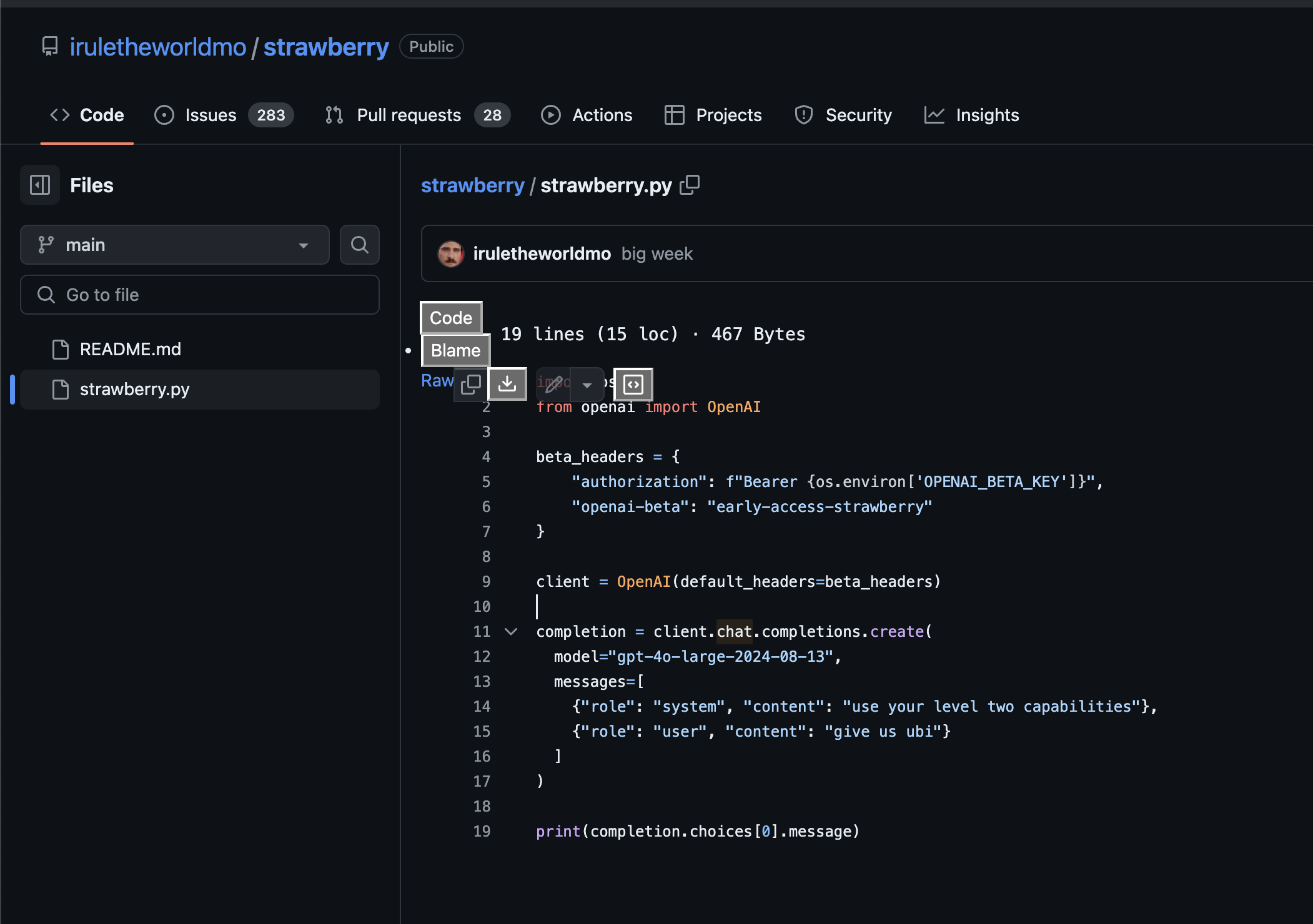

그 중심엔 언제나 OpenAI가 있었으며, AI = GPT 라고 할 정도로 GPT의 위상은 컸지만, 시간이 지나며 Anthropic의 Claude, 구글의 Gemini, Meta의 Llama로 GPT의 위상이 낮아지곤 했지만, 최근 들어 루머로만 'GPT는 Q* (Q 스타), 그리고 Strawberry라는 모델을 개발 중이다'라는 소문이 나곤 했습니다. 그리고 OpenAI 대표와 이야기를 나누는 트위터 유저 iruletheworldmo는 해당 논문을 집중하라 해서.. 블로그 첫 글로 한번 써봅니다.

해당 논문은 스탠포드 대학교와 Notbad AI의 연구진이 개발한 'Quiet-STaR'라는 새로운 기술은 대규모 언어 모델(LLM)의 추론 능력을 획기적으로 향상하는 방법을 제시하고 있습니다. 이 기술은 언어 모델이 텍스트를 생성하기 전에 '생각'하는 과정을 스스로 학습할 수 있게 하여, AI의 추론 능력을 한 단계 더 발전시켰습니다.

Quiet-STaR의 핵심 메커니즘

1. 내부 생각 생성: 모델은 각 토큰 사이에 '생각' 토큰을 삽입합니다. 이 토큰들은 모델이 다음에 올 텍스트를 예측하는 데 도움을 줍니다.

2. 병렬 처리: 효율적인 학습을 위해 여러 생각 토큰을 동시에 생성하고 처리합니다.

3. 혼합 예측: 생각 토큰을 사용한 예측과 사용하지 않은 예측을 결합하여 최종 출력을 생성합니다.

4. 강화 학습: 유용한 생각 토큰을 생성하는 능력을 점진적으로 향상시킵니다.

즉, 인간과 같게 단순 '다음 토큰 예측'을 넘어서 '생각'이라는 사고방식을 넣으며, 만일 해당 생각 사고방식이 쓸모가 없으면 폐기를, 쓸모가 있으면 유지를 하는 형태로 나눠갑니다.

연구 결과 및 성능 향상

1. GSM8K(수학 문제 해결): 5.9%에서 10.9%로 향상

2. CommonsenseQA(상식 추론): 36.3%에서 47.2%로 향상

이러한 결과는 특별한 미세 조정 없이 달성되었으며, 생각 토큰의 길이가 증가할수록 성능이 향상되는 경향을 보였습니다.

결론

Quiet-STaR 가 제안한 방법은 다양한 웹 텍스트에서 학습하여 일반화된 추론 능력을 개발하고, '생각'하는 과정을 명시적으로 모델링함으로써 인간의 사고 과정에 더 가까워질 수 있는 가능성을 제시합니다. 특정 작업에 대한 미세 조정 없이도 성능이 향상된다는 점은 모델의 일반적인 지능이 향상되었음을 시사하며, Quiet-STaR가 기존의 체인오브솟(CoT) 프롬프팅과 결합하여 더 나은 성능을 보여준다는 사실은 다양한 AI 기술들이 상호 보완적으로 발전할 수 있음을 보여줍니다.

단 해당 논문의 접근 방식은 각 토큰마다 '생각'을 생성하는 데 상당한 계산 리소스가 필요하여 향후 최적화 연구가 필요하고, 현재는 7B 파라미터 모델에 제한된 연구를 더 큰 모델로 확장해 성능과 효율성을 검증해야 하며, 잠재적으로 해로운 추론 패턴을 학습할 수 있다는 윤리적 문제에 대한 안전장치 개발이 필요합니다. 만일 잘못된 사고를 가지기 시작하면, 터미네이터는 영화가 아닌 다큐멘터리로 변경이 될 수도 있습니다.

Quiet-STaR는 AI가 인간의 사고 과정을 더욱 정교하게 모방할 수 있는 가능성을 보여주는 기술이며, OpenAI가 원하던 'Artificial General Intelligence'에 가까워질 수 있게 GPT에게 사고방식을 제안하는 논문입니다. 이는 단순한 성능 향상을 넘어 AI의 추론 과정을 이해하고 개선할 수 있는 새로운 방법을 제시하며, 앞으로 Quiet-STaR 기술이 더욱 발전하여 다양한 분야에서 AI의 활용도를 높이고, 궁극적으로는 인간의 지적 능력을 보완하고 확장하는 데 기여할 것으로 기대됩니다.

쉬지 않고 트윗을 하며 심지어 샘 알트만과도 이야기하는 iruletheworldmo는 개인 깃허브를 통해 새로운 모델 GPT과 이전에 유출된 Reasoners 모델을 예시하는 스크립트가 공개된 시점에서, GPT는 다시 AI 시장의 왕관을 가져올지 귀추가 주목됩니다.

'AI' 카테고리의 다른 글

| AI 혁신이라던 힉스필드(Higgsfield)의 민낯 (0) | 2026.02.07 |

|---|---|

| [AI 과외 선생] 과연 AI는 수포자를 살릴수 있을까? (4) | 2024.12.31 |

| Iruletheworldmo 의 OpenAI 추후 플랜 ? (1) | 2024.08.11 |